2025-9-15

体现:此工作做到最大程度能够投TPAMI,

目标:是什么?数据到多少?方法?任务?

第一阶段:要达到什么程度?

意义?价值?

- 最近在 TPAMI(或近年 TPAMI 级别)发表的与 segmentation / Transformer / dataset 相关的代表性工作;

- 如果论文同时收集并发布数据集,这些数据集通常的规模范围是多少(给出示例和参考)。

一、TPAMI / 近年高水平期刊上有关 Segmentation / Transformer 的代表性工作(快速导览)

- Transformer 在视觉分割方向的综述(TPAMI, 2024) — 系统总结了 transformer-based segmentation 的架构、任务(语义/实例/全景/视频)与数据集,是理解这个领域最新方法的起点。(ResearchGate)

- TPAMI(或同等级期刊)近两年也发表了多篇与 Transformer / segmentation / video segmentation 相关的方法学论文,例如关于 “全景/全景畸变下的 transformer 适配” 和“多类 token/弱监督定位” 等(各论文侧重不同任务:全景语义分割、视频对象分割、弱监督分割等)。这些文章展示了 Transformer 在不同分割子任务上的活跃应用与改进方向。(ACM Digital Library)

说明:综述 + 方法学论文表明 —— TPAMI 非常欢迎把新架构(如 Transformer + 新训练范式/任务适配)和严谨的大规模实验(包含标准基准)结合起来的工作,这正符合你将 RL 模块引入 segmentation 的方向(方法创新 + 严格实验)。

二、如果论文同时发布数据集,典型的数据集规模(按任务/领域给出参考区间与示例)

结论先行:分割类数据集规模差异很大,取决于领域(通用场景 vs 城市街景 vs 专用领域如医学/水下/遥感)——从几千张到几十万/几百万标注实例均有出现。下面是有代表性的实例与准确规模来源,可直接引用。

- 通用语义/实例分割基准(中大型)

- MS COCO(通用 detection/segmentation):约 ~330k 张图(其中 ~200k 有标注),约 1.5M 实例,是检测/实例分割与“stuff”分割的常用大基准。适合验证模型在复杂自然场景下的泛化能力。(cocodataset.org)

- ADE20K(场景解析):约 27k 张(训练 ~25k,val 2k),适合 scene-parsing / 多类语义分割评测。(ade20k.csail.mit.edu)

- Cityscapes(城市街景语义分割):高精度标注的 5k 张精标图(另有 ~20k 粗标),是自动驾驶/街景分割的标准小样本高质量基准。(cityscapes-dataset.com)

- 领域/任务依赖的中小型到大型数据集

- 总体规律(经验总结,便于你 PPT 写“数据规模选择”部分):

- 若目标是 TPAMI 水平的“方法+数据”贡献:一般至少需要 数千张像素级标注,并配套合理的 train/val/test split 与 baselines(越是通用任务,越倾向于更大的数据规模或在多个公开基准上做完整对比)。(上面列举的 COCO、ADE20K、Cityscapes 给出了可参考规模)(cocodataset.org)

- 发布新数据集时:若领域专属性强(例如中式混合菜品分割),1k–10k 张高质量像素标注可以作为有价值的贡献(前提:数据难度/新颖性明确、annotation 标准/示例充分、并且公开基准和评测协议设计到位);若要更有“震撼力”或和 COCO 级别竞争,则需要向 数万(甚至更大)规模扩展,但成本和工作量显著上升。上述区间也与近年 TPAMI/顶会中数据集发布的常见规模一致(领域不同规模差异大)。(ade20k.csail.mit.edu)

三、给你做研究/投稿(TPAMI)时关于数据集规模的具体建议(可直接放进 PPT)

- 若你的贡献以“方法为主,数据为辅”(你现在已有 MixFood500 / FoodDet100k 的想法):

- 把现有 MixFood500 发展成 高质量像素分割版(建议至少 1k–5k 张像素标注,并明确 train/val/test 划分与标注规范),同时在 ADE20K / COCO-stuff / Cityscapes 或 FoodSeg 等公开集上做跨域验证,能显著增强说服力。(ade20k.csail.mit.edu)

- 若你希望同时以“数据集+方法”作为卖点(更高难度,投稿吸引力更大):

- 争取至少 >10k 张 的像素级标注或通过高质量半自动标注+大规模合成(Stable Diffusion + copy-paste / SAM 辅助)扩增到 万级,并做详尽基准、协议与baseline(这符合许多 TPAMI 数据/方法联合论文的做法)。参考近年领域数据集规模与方法论文的做法。(arXiv)

四、参考(便于你把来源直接放到论文/PPT 参考文献页)

- Xiangtai Li et al., Transformer-Based Visual Segmentation: A Survey, IEEE TPAMI, 2024. (ResearchGate)

- MS COCO official / arXiv paper, Microsoft COCO (dataset stats page). (cocodataset.org)

- ADE20K (MIT CSAIL) dataset page / CVPR paper. (ade20k.csail.mit.edu)

- Cityscapes dataset website / overview. (cityscapes-dataset.com)

- VisDrone dataset / repo (示例:大规模帧+标注的领域数据). (GitHub)

- 领域性小/中数据集示例(如 UIIS10K underwater dataset)说明“专用领域数据规模常在几千—一万左右”。(arXiv)

五、我可以接着为你做的事(二选一,直接选即可)

A. 把上面内容整理成5–8 页 PPT(中文):包含研究动机、方法亮点、数据计划(规模/采集/标注策略)、第一阶段实验目标与时间表、与 TPAMI 要求对应的评估/基线。

B. 按 TPAMI 要求,把MixFood500 → 分割版的数据集设计成一个“可提交方案”(标注规范、样本量建议、合成扩充策略、baseline 列表、评测协议),并估算标注工作量(人工小时数)与提升优先级。

你想让我直接把 5–8 页 PPT 做出来(选 A),还是先生成“数据集设计方案”文档(选 B)?我会把相应内容做成可下载的 PPT 或 Markdown(直接产出,不会要求你等)。

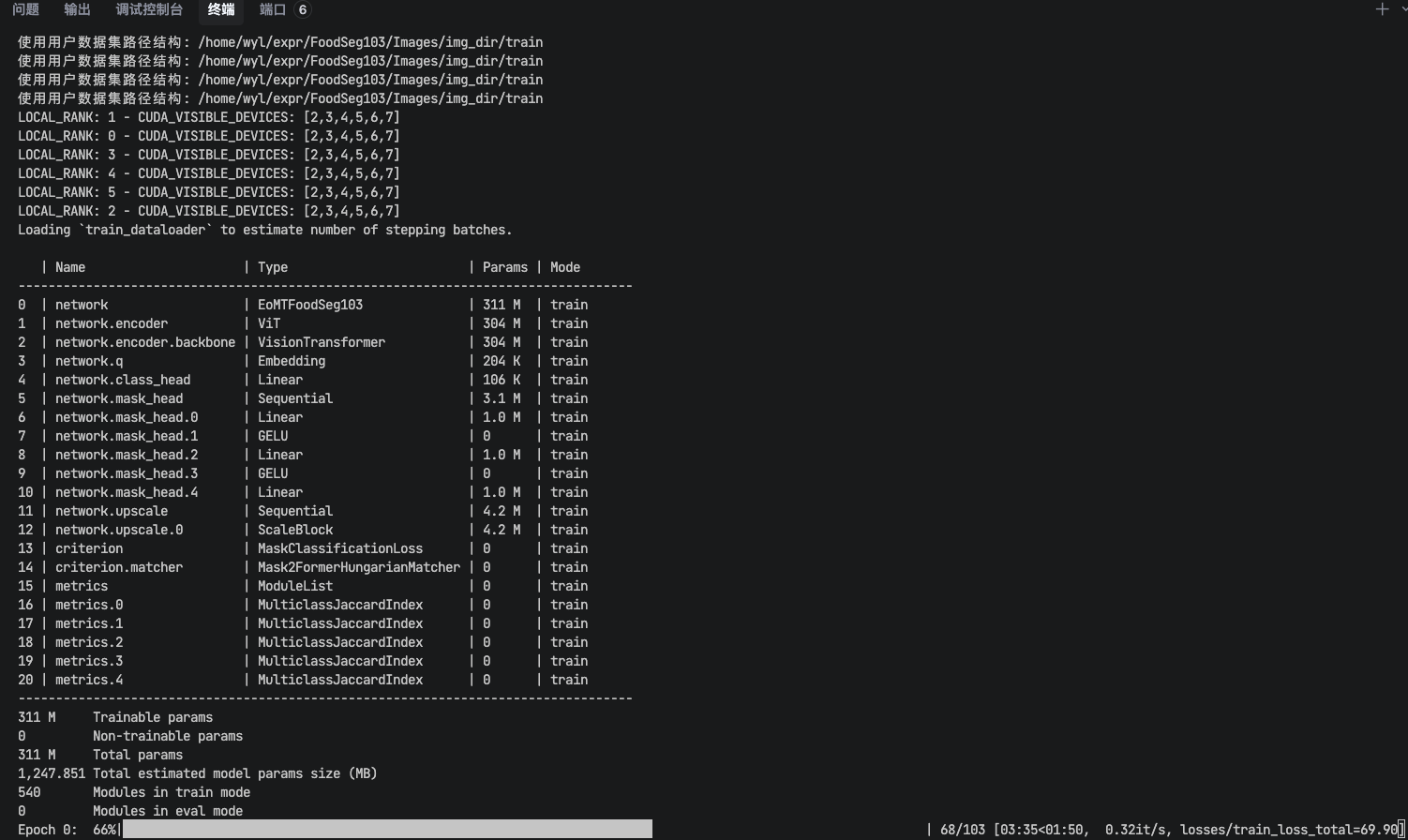

无语住了,总算是能运行了。

和09服务器干了几天,最终还是无力败退,毕竟cuda117的版本也太低了,搞得很多库安不了、版本不匹配、真的难绷。

实打实弄了感觉都快一个星期了。上个星期三就已经能在本地跑了,结果部署到服务器上居然是如此的麻烦,当然这个还得“归功”于难绷的cuda版本。

今天用20服务器,于是很快就能安装配置好环境,差不多也就是几个小时。