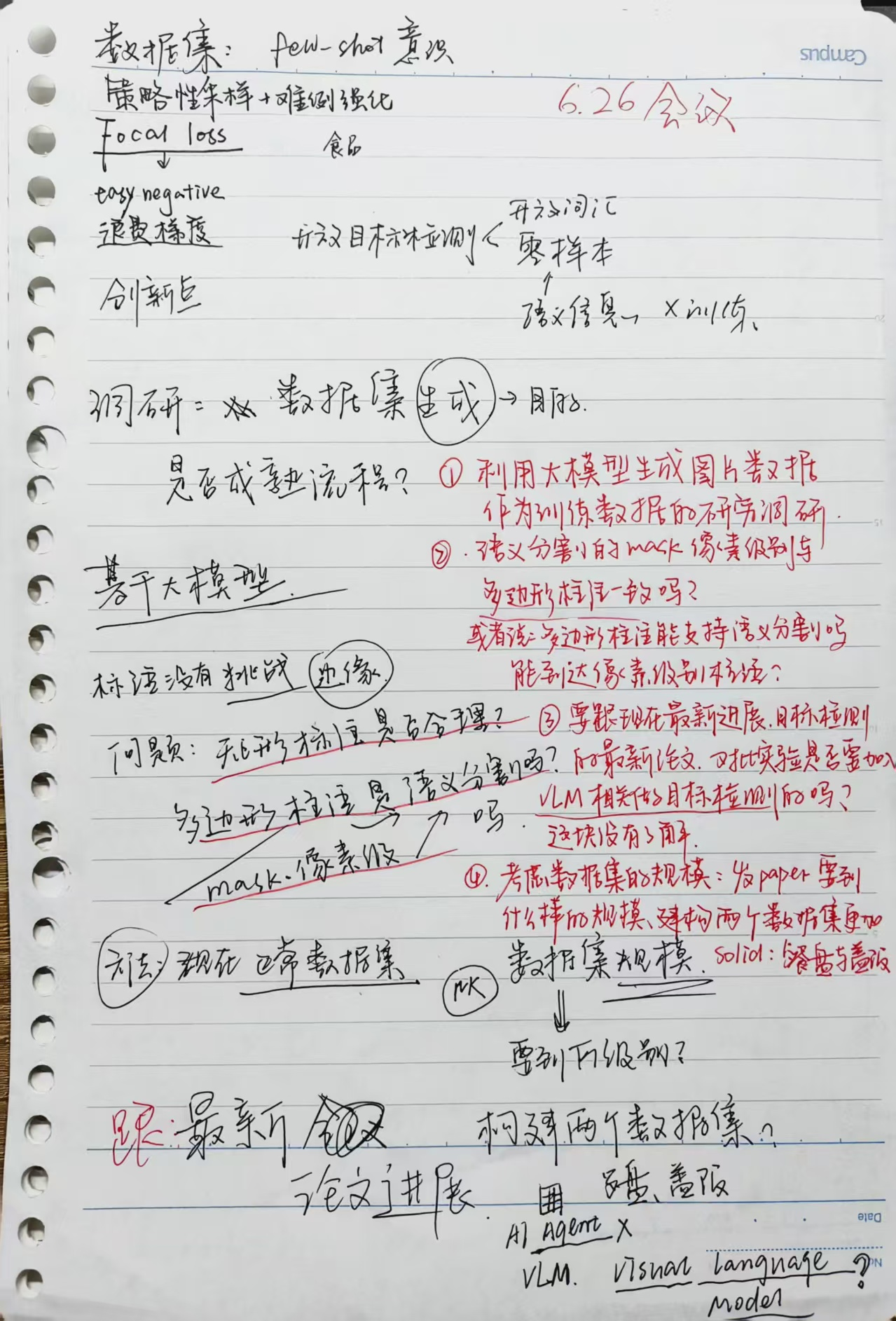

2025-6-26-会议记录

会议记录

今天又开了一下会,感觉那位大四的同学基础确实有一些薄弱。既然是数学专业,依我之见,就该扬长避短。首先,你需要对你所看的论文的大体概念需要了解,而不是泛泛的看,看了半天居然连主题是什么都不知道。比如最简单的识别与检测的区别;目标检测中开放目标检测->开放词汇检测和零样本检测的区别;再者,对于数学公式的推导不应囫囵吞枣,如何能够有趣、或是简练地总结。

零样本检测(Zero-Shot Detection, ZSD)和开放词汇检测(Open-Vocabulary Detection, OVD)都属于开放世界目标检测(Open-World Object Detection)的研究范畴,它们都旨在识别未在训练集中出现过的类别,但侧重点不同,主要区别如下:

- 零样本检测:在完全没见过目标类别的情况下进行检测,只依赖语义信息(如文本描述)。eg.训练集里没有“斑马”,但给定“具有黑白条纹的大型动物”的语义描述,模型能检测斑马。

- 开放词汇检测:同时检测已知类别和未见过类别,通过大规模词汇表支持灵活扩展。eg.训练集中没有“电动滑板车”类,但模型可以从包含“电动滑板车”的词表中识别它。

| 对比维度 | 零样本检测(ZSD) | 开放词汇检测(OVD) |

|---|---|---|

| 定义 | 不使用目标类别图像,仅用语义信息检测新类别 | 在训练时只用部分类别,但测试时支持更大词汇表 |

| 目标类别 | 测试时目标类别在训练集中完全缺失 | 测试时目标类别可能在训练中没见过,但来自开放词表 |

| 训练类别数量 | 通常较小,关注训练-测试类别间泛化能力 | 训练类别有限,但借助大词表提升可扩展性 |

| 语义辅助 | 强依赖类别的语义嵌入(如词向量、文本) | 多使用视觉语言对齐模型(如 CLIP) |

| 任务难度 | 更强调“未见类”的泛化能力 | 更关注对大规模类别的适应能力 |

| 典型方法 | 基于属性嵌入/语言嵌入匹配 | 基于视觉-语言预训练(如CLIP/ALIGN) |

| 应用场景 | 检测一些训练时完全没有的类别(如稀有物种) | 像搜索引擎一样根据任意词汇检测对象 |

还有就是在对比实验结果上:为什么seen的mAP会比unseen的mAP高?有可能是以下的原因:

- 训练类别的“过拟合”现象

- 由于模型在训练集上反复学习 seen 类别,它可能在训练类上过拟合,导致对这些类的表示过度专用(specialized),反而降低泛化能力。

- 在测试时,模型可能无法很好地区分这些“相似但过拟合”的 seen 类别。

➡️ 表现为:模型在 seen 类别中出现混淆,mAP 被拉低;而对 unseen 类别,由于使用的是共享语义空间(如词向量),反而更加“中立”和泛化。

- 类间不平衡(Semantic Bias)

- 有些 seen 类别在训练中频率较高(类不平衡),模型更偏向这些类别,导致预测时置信度分布不均衡。

- 而 unseen 类别一般采用统一语义嵌入处理,更容易形成清晰的决策边界。

➡️ 尤其是在:基于属性嵌入(Attribute Embedding)或基于语言嵌入的 ZSD 中更明显。

- 测试集分布差异

- 有些数据集(如 aPY、AWA)中,unseen 类别在视觉上更容易识别(更显著、背景更干净),而 seen 类别可能更加多样或复杂。

➡️ 这会导致:测试时模型在视觉上对 unseen 类别表现反而更好。

- 模型结构或损失函数偏向 unseen

- 有些零样本方法(比如基于 compatibility score 的匹配)天然更适合推理 unseen 类别,因为它们的嵌入空间没有因训练类的监督而受到“干扰”。

- 比如在 GZSL(Generalized Zero-Shot Learning)中,如果使用 softmax over all classes,可能严重偏向 seen 类,但若只测试 unseen,反而表现更高。

会议总结

总体来说,在数据集的构建上比较合理,也有相关的对比实验的设计。(但是其实是我用GPT随便生成应付的),但是这么说也不大对,毕竟我确实有看YOLOv10/11也跑了,还算是比较新的方法。但是DINO/Deformable DETR之类倒是没看,还是要抽时间看。

存在问题

利用大模型生成图片数据作为训练数据、这样的研究有吗?去调研一下。—相关工作,详细、全面、深入

语义分割的数据要是mask级别、多边形标注的数据、能够满足像素级的mask吗?—多标几个。

对于数据集的规模数量还要多思考:为什么现在的数据集规模是这个样子?有什么依据?不要想当然。至于数据集的个数:因为如果只有一个数据集的话,不够solid;最好设计两个数据集。目前看来就是现有的餐盘500张与再从0收集的盖饭数据集。

跟进现在最新的目标检测进展:每天都要看arxiv上的最新。目前来看做目标检测的研究数量如何、发paper如何?再就是结合VLM(Visual Large Model)的目标检测的相关研究、是否也要加入对比实验?

大模型目前的实验结果。

给出一个方案,多边形/像素/大模型目前效果

是否ke’xue

如果说VLM的规模很大,就凭我这8张3090能跑的起来吗?