多元统计分析-Ch8-判别分析

Ch8 判别分析

[TOC]

8.0 引入

对观测到的样本判断它属于哪个总体(类)。实际上就干一件事:分类样本。

判别分析的数学描述:已知有k个总体(类)

8.1 距离判别

假设有两个正态总体

扩展欧式距离—>马氏距离(Mahalanobis距离)

设

和 是来自于均值为 ,协方差阵为 的总体 的两个样本,定义样本之间的马氏距离为: 定义

与总体的距离为 与均值 的距离,即:

8.1.1 总体具有相同协方差的情形

假定两个总体

我们先考虑总体

思路:利用样本到总体的马氏距离进行判断。

样本到总体的距离差为:

记:

有:

判别准则为:

若记

则称

注:上述结果可以推广到非正态分布的情形,只需知道均值和协方差。

A.总体参数未知的情形

当

假设已知有总体

需要注意的是

判别准则同上:

B.多个总体的判别问题

定义:令

称

(1) 总体参数已知的情形

设有

判别规则为:

其中:

若

(2)总体参数未知的情形

假设有来自总体

记

则判别函数为:

判别规则仍为:

8.1.2 总体协方差不同

假设有

总体参数已知

令:

则判别规则为:

总体参数未知

使用样本均值和样本协方差阵来估计样本,需要注意的是

令:

则判别规则同总体参数已知。

8.2 贝叶斯判别

对样本来自哪个总体的可能性有一定的认识,才使用贝叶斯判别。

问题描述: 设有

判别规则为:

8.2.1 贝叶斯判别法则

记

假定样本

这等价于,

| 贝叶斯判别法则 | 求解最优划分 |

|---|---|

| 误判概率(同时发生将其判别为j&误判i) | 给定划分 |

| 判别的平均损失 | 给定划分 |

贝叶斯判别法则就是选择划分

注1: 假定划分

不包含边界。 因此边界 。 假定:若样本

,则 , 即边界的测度为0。 Q: 测度为0?

A: 边界的测度为0表示边界是“低维流形”,在高维空间中,它的体积(或者概率质量)可以忽略不计。概率论上,如果一个集合的测度为0,则样本落在该集合上的概率为零。

- 在一维空间,边界是点(0维),其测度为0。

- 在二维空间,边界是曲线(1维),其面积为0。

- 在三维空间,边界是曲面(2维),其体积为0。

边界测度为0的含义: 贝叶斯判别中,区域边界是由等式

定义的,其中 是将样本 y 判为类别 的贝叶斯风险。边界的测度为0意味着: . 这表示:

- 从概率的角度,样本几乎不可能恰好落在边界上。

- 但这并不严格保证“没有样本落在边界上”,因为对于有限样本,可能存在样本 y 落在边界上。

Q: 为什么边界测度为0很重要?

A: 边界测度为0的性质使得贝叶斯判别区域的定义是严格划分的,区域之间互不重叠,且几乎覆盖整个样本空间; 确保贝叶斯判别的理论正确性。

- 由于边界的概率质量为零,样本落在边界上的概率可以忽略不计。

- 因此,贝叶斯判别规则在实际应用中是稳定的,不会因为边界问题产生重大影响。

8.2.2 样本空间中不同类别之间的判别边界测度为0

积分区域不同,只有两者相交的地方才是0(?)

定理8.1:当先验概率

贝叶斯划分边界的测度为0:

证明: 若令

,则平均损失为: 若空间

存在另一个划分 ,其平均损失为: 则:

而由

的定义,知在 上 对一切 成立,故: 说明

使得平均损失达到极小,它就是贝叶斯判别的解。 再由 知, 对任意 成立。 而边界由集合 交并运算构成,因此是测度 意义下的零测集。

注2:

事实上,对任意

由定理8.1得贝叶斯解。

8.2.3 贝叶斯判别的容许性

Q: 容许估计?

A: 对于一个估计量

,如果存在另一估计量 ,使得 , ,且至少对一个 严格不等,则称 为不可容许的。 如果不存在上述性质的 ,则称 为可容许的。 要求估计必须是可容许的,就是在要求“风险一致最小”,在大多数情况下可容许的估计是有偏的。

定理8.3 (容许性) 若

这与

例子(什么,是栗子,吃一口)

例8.4 设两个总体

由(10)知

取对数回到前面的距离判别。

化简后不难推得

由(1)式即知

当

真正的贝叶斯是基于后验概率,进行判别:

注4:基于后验概率的判别 当样本

因为密度估计本身存在困难,所以贝叶斯估计只是理论上成立的。

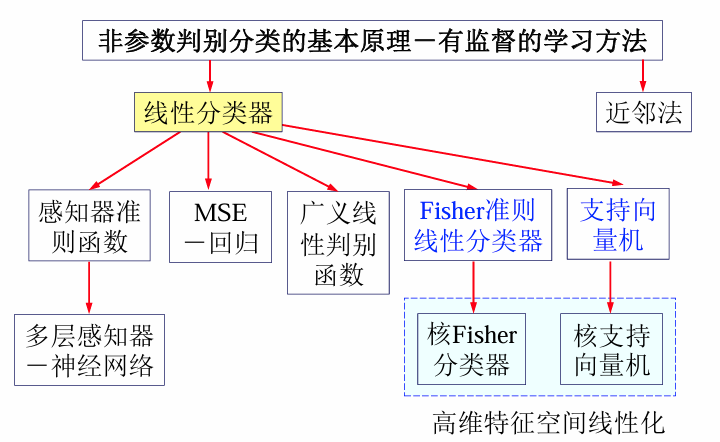

8.3 Fisher 判别

总体协方差阵相同、距离判别+正态总体下贝叶斯判别—>线性判别函数。

当总体的协方差阵相同时,距离判别以及正态总体下的贝叶斯判别都导出一个线性判别函数。

8.3.1 线性判别函数

设

令:

Fisher准则:选取

称

记

定理8.5 :假设

证明:利用二次型的极值性质得。

注5:当

, 时,Fisher准则下的线性判别函数和判别效率为 事实上,此时

, 。 不难推知 是 的特征向量,其对应非零特征根是:

总体参数未知的情形

基于训练样本可以估计总体的均值和协方差阵,进而得到线性判别函数为

注6: Fisher准则的判别函数不唯一。

事实上,假设

即

8.3.2 Fisher判别准则

对于线性判别函数

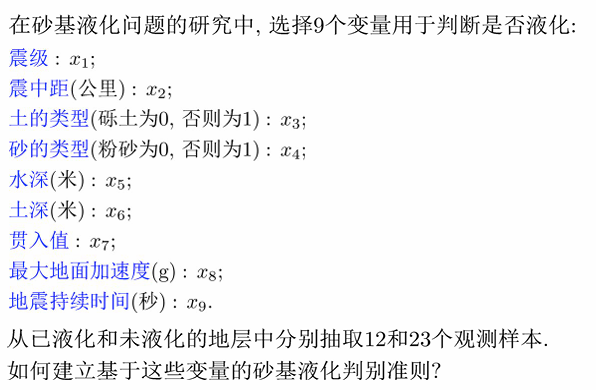

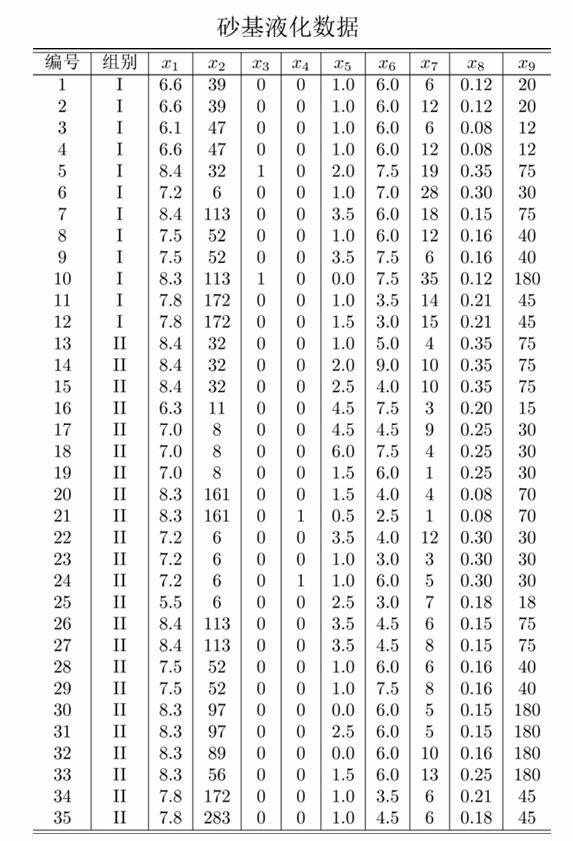

8.4 判别分析实例

8.5 误判概率

考虑两个正态总体的情形.

记

其中

8.5.1 误判概率:总体参数未知的情形

定理8.6 当

其中

证明:

是线性函数,因此它服从正态分布,且 : 即知

。同理可知:

推论8.7 当

“d”的确定:

误判概率最小化:即要求:

方程的解为

,与距离判别一致。 误判损失最小化:即要求:

求解方程即可得

。 注9:由

式知, 越大,误判概率越小。 越大, 与 的马氏距离越大,即两个总体越分得开。

类似地,基于训练样本可得判别函数:

定理8.8

由定理8.8可得如下误判概率的估计:

其中

还可以利用

基于误判概率估计,可以使误判概率极小化来确定

进一步,可以由

8.5.2 基于误判概率的判别方法

假设正态,基于误判概率, 适用面窄

考虑

那么平均误判概率为:

以正态总体

不难计算得:

求解